2025年6月30日,华为高调宣布开源其盘古大模型核心组件(Pangu Pro MoE),包括70亿参数稠密模型和720亿参数的混合专家模型,宣称这是构建昇腾生态的关键举措。

然而仅隔四天,一项发布于GitHub的研究引发业界关注:用户@HonestAGI通过“LLM指纹”技术分析指出,盘古Pro MoE与阿里通义千问Qwen-2.5 14B模型的注意力参数分布相似性高达0.927(1.0为完全一致),远超业内0.7以下的正常差异范围。

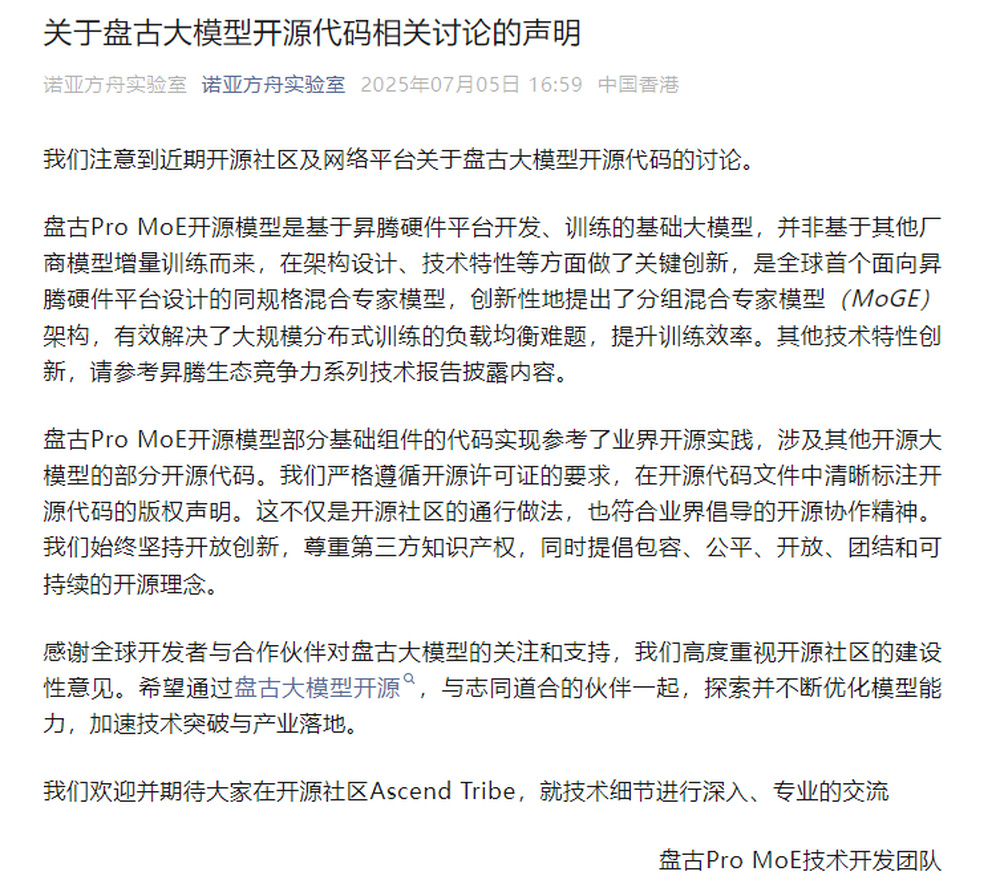

华为诺亚方舟实验室声明截图

华为诺亚方舟实验室声明截图

华为诺亚方舟实验室7月5日发布最新声明,表示盘古 Pro MoE 开源模型是基于昇腾硬件平台开发、训练的基础大模型,并非基于其他厂商模型增量训练而来。

盘古团队表示,“盘古 Pro MoE 开源模型部分基础组件的代码实现参考了业界开源实践,涉及其他开源大模型的部分开源代码。我们严格遵循开源许可证的要求,在开源代码文件中清晰标注开源代码的版权声明。这不仅是开源社区的通行做法,也符合业界倡导的开源协作精神。”

然而,就在7月6日凌晨,一位自称是盘古大模型团队的员工自曝,确实存在套壳、续训、洗水印的现象。

此爆料文章来源不明,无法确认其真实性。

截至目前,华为方并未对此爆料内容发表声明。

来源:新浪科技、诺亚方舟实验室、云头条

编辑:杨子梦